Vers une revue systématique plus efficace : peut-on se soustraire à une double revue humaine avec l’IA ?

21 nov. 2025

5 Min de lecture

IA

L’article montre qu’avec la supervision humaine, l’IA, comme celle de NOÉ, peut remplacer un second reviewer tout en garantissant rapidité, fiabilité et rigueur scientifique.

Introduction

Traditionnellement, deux reviewers sont mobilisés pour limiter les biais. Mais avec l’émergence des outils basés sur le machine learning (ML), l’approche a été bouleversée. Sont-ils assez fiables pour se substituer au second reviewer ?

Ce que dit LA GUIDANCE PRISMA 2020 EXPLANATION AND ELABORATION: UPDATED GUIDANCE AND EXEMPLARS FOR REPORTING SYSTEMATIC REVIEWS

Dans la guidance PRISMA 2020¹ , il est clairement indiqué que les outils d’automatisation peuvent être utilisés : « whether they were used in lieu of or in addition to human reviewers »

Concrètement, cela veut dire qu’un seul reviewer humain peut être assisté par un outil d’automatisation, notamment pour l’exclusion des études manifestement non pertinentes ou pour prioriser le screening.

Il y a-t-il des conditions pour lesquelles l’IA peut remplacer un second reviewer ?

Dans la guidance PRISMA 2020, pour cela il faut :

Déclarer clairement l’usage de l’outil, sa fonction (tri, exclusion, priorité) et son rôle dans la chaîne de décision.

Montrer que l’outil a été validé et qu’un seuil de performance acceptable a été atteint (Chaque solution fixe un seuil de performance, chez Noé nous l’avons fixé à plus de 95%).

Prévoir une revue humaine des cas ambigus ou limites.

Performance des outils de machine learning : que disent les études ?

Plusieurs outils comme AbstrackR ou Rayyan ont déjà montré que l’IA pouvait accélérer le screening des revues systématiques, avec une qualité acceptable².

Mais jusqu’ici, peu d’études comparaient directement ces approches à un double screening humain.

L’étude publiée en mars 2025 dans Research Synthesis Methods intitulé “Machine learning for identifying randomised controlled trials when conducting systematic reviews: Development and evaluation of its impact on practice” ³ change la donne : elle propose une comparaison claire de deux stratégies d’intégration de l’IA, et permet d’évaluer précisément son efficacité face aux méthodes traditionnelles.

Stratégie 1 – Screening parallèle : l’IA comme reviewer à part entière

Dans cette stratégie, l’IA réalise le screening complet de tous les résumés, exactement comme le ferait un reviewer humain.

En parallèle, un reviewer humain lit et sélectionne de manière indépendante les mêmes abstracts.

Chaque système (IA et humain) émet son propre jugement sur chaque résumé.

En cas de désaccord, un arbitrage est réalisé (par consensus ou via un troisième avis).

C’est donc un double screening complet, avec un reviewer remplacé par une IA.

Résultats :

Rappel (proportion d’articles pertinents correctement inclus) > 99,8 %

Gain de temps significatif (~45 %)

Très faible risque d’omission

Stratégie 2 – Screening hiérarchisé : l’IA filtre, l’humain vérifie uniquement ce qu’elle propose

Dans ce modèle, l’IA passe seule sur l’ensemble des abstracts en premier et classe les documents en deux catégories : potentiellement pertinents vs probablement non pertinents.

Seuls les résumés jugés pertinents par l’IA sont ensuite relus par un reviewer humain.

Les autres sont directement exclus, sans relecture humaine.

C’est une approche encore plus rapide, mais qui repose sur une confiance forte dans le tri initial réalisé par l’algorithme.

Résultats :

Gain de temps très élevé (~74 %)

Rappel légèrement inférieur (97%) : certaines études pertinentes marginales peuvent être perdues, car jamais revues par un humain.

Conclusion de l'étude : une collaboration IA + humain optimale

L’étude conclut que le meilleur compromis entre qualité de sélection et efficacité temporelle est obtenu avec la stratégie de screening parallèle.

Ce modèle préserve un haut niveau de fiabilité (rappel > 99,8 %), tout en réduisant considérablement la charge de travail.

À l’inverse, le screening hiérarchisé – bien que plus rapide – peut conduire à écarter par erreur certains articles pertinents, ce qui peut nuire à la robustesse d’une revue systématique.

Noé : un modèle hybride supervisé, inspiré du screening hiérarchisé

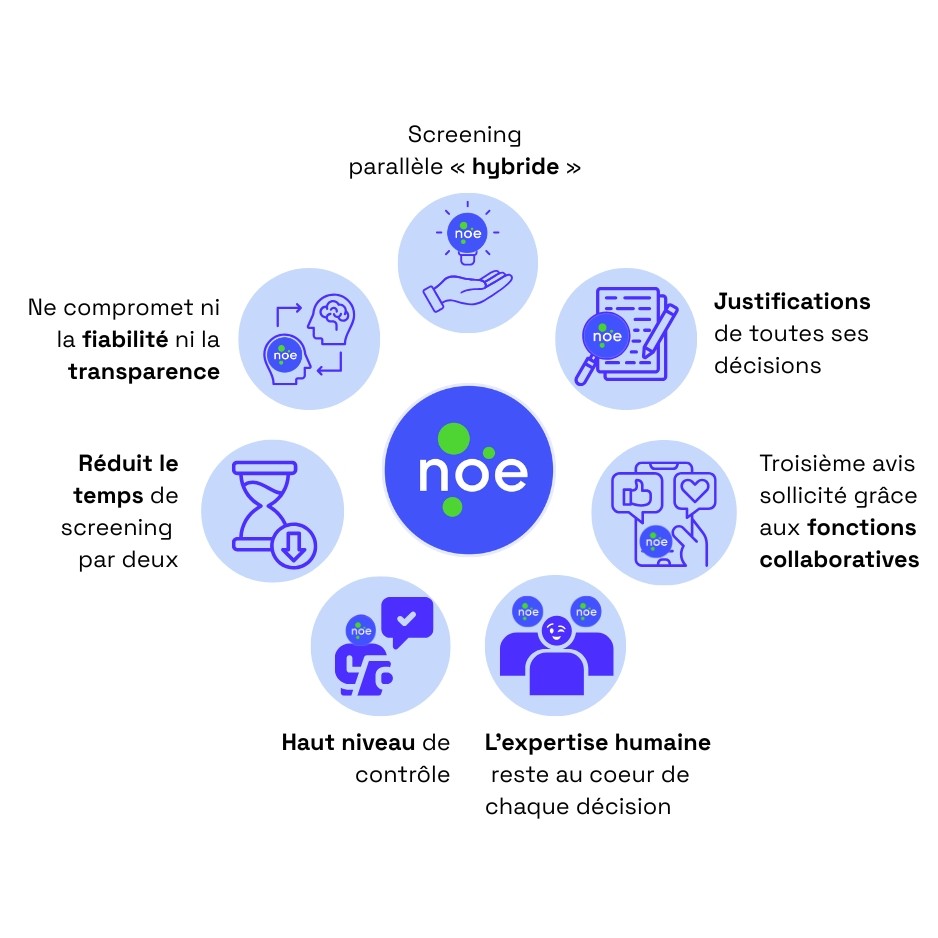

Noé propose un screening parallèle « hybride » : le reviewer humain et l’IA relisent de manière indépendante les mêmes abstracts.

L’IA explique toutes ses décisions d’inclusion/d’exclusion. En cas de désaccord, un arbitrage par l’expert est réalisé, un troisième avis peut également être sollicité, grâce aux fonctions collaboratives de la plateforme.

L’expertise humaine reste au cœur de chaque décision. Ce fonctionnement permet de conserver un haut niveau de contrôle, tout en réduisant le temps de screening par deux, sans compromettre la fiabilité ni la transparence de la méthode.

Noé permettrait ainsi de se passer d’un second reviewer, tout en respectant les exigences de transparence, de traçabilité et de rigueur méthodologique définies par PRISMA.

IA contre erreur humaine

Au-delà des gains d’efficacité, l’apport de l’IA se manifeste aussi dans la réduction des erreurs humaines, même chez les reviewers expérimentés. C’est ce que démontrent plusieurs études, ouvrant la voie à une réflexion plus large sur la fiabilité du screening manuel.

Plusieurs études ont montré que les erreurs de screening sont fréquentes, même chez des reviewers humains expérimentés. Selon Waffenschmidt et al. (2019)⁴, jusqu’à 13 % des études pertinentes peuvent être exclues à tort lors d’un screening manuel en simple reviewer.

L’utilisation d’un algorithme permet de :

Réduire les variabilités inter-individuelles (liées à la subjectivité ou à la fatigue),

Appliquer des critères de sélection de manière constante, diminuant ainsi le risque

d’exclusion erronée.

C’est ce que confirment également Gates et al. (2019)⁵, qui montrent qu’une IA bien entraînée peut atteindre des performances supérieures à celles d’un reviewer humain seul, tout en réduisant le temps de traitement de 30 à 50%.

Dans cette perspective, utiliser une IA permet non seulement de gagner en efficacité, mais aussi en sécurité méthodologique, en limitant les biais de sélection.

Vers une adoption professionnelle de l’IA dans le screening

Noé s’inscrit pleinement dans l’évolution méthodologique des revues systématiques, en proposant une IA dédiée, déjà opérationnelle, qui respecte les standards de transparence et de validation définis par PRISMA 2020.

Loin d’être un simple concept, Noé est conçu pour une intégration concrète dans les pratiques professionnelles, avec :

une supervision humaine systématique,

un apprentissage progressif des critères de sélection spécifiques à chaque projet et,

Une traçabilité de toutes les décisions.

Noé offre une solution équilibrée, fiable, qui s’inscrit dans une nouvelle logique hybride collaboration entre IA et humain.

Les approches comme le screening parallèle ou supervisé permettent de combiner rapidité, fiabilité et traçabilité, à condition que l’humain reste impliqué dans la validation finale.

Autrement dit, une double revue humaine n’est plus toujours indispensable. La question n’est plus de savoir si l’IA peut remplacer un second reviewer, mais dans quelles conditions elle peut le faire sans nuire à la rigueur scientifique.

Les récents travaux sur le sujet et l’analyse des dernières recommandations ont montré qu’un reviewer humain, assisté par une IA, peut suffire dans de nombreux contextes, à condition que l’IA utilisé respecte les standards de transparence et permette un contrôle humain clair.

On peut en conclure qu’aujourd’hui certaines conditions sont réunis pour adopter l’IA dans la phase de screening.

Références bibliographiques :

Gates, A., Guitard, S., Pillay, J., Elliott, S.A., Dyson, M.P., Newton, A.S., & Hartling, L. (2019). Performance and usability of machine learning for screening in systematic reviews: a comparative evaluation of Abstrackr and a novel tool using a randomized controlled trial dataset. Systematic Reviews, 8, 278. https://doi.org/10.1186/s13643-019-1185-3